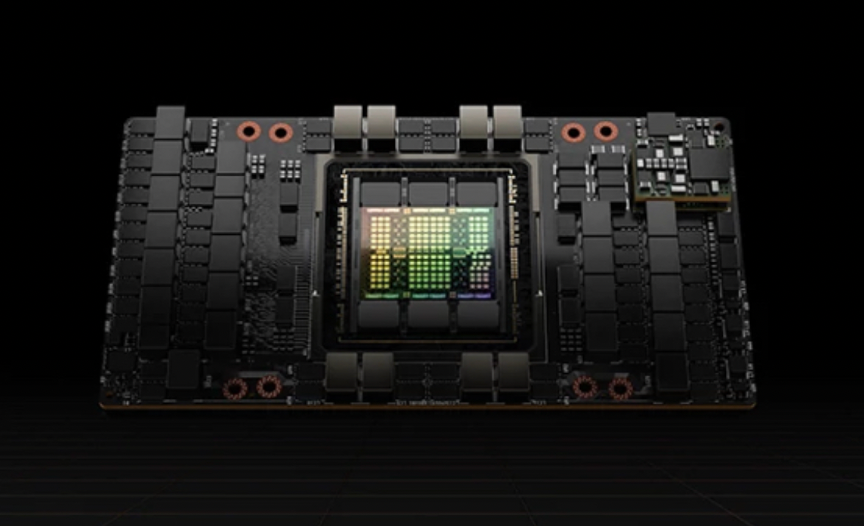

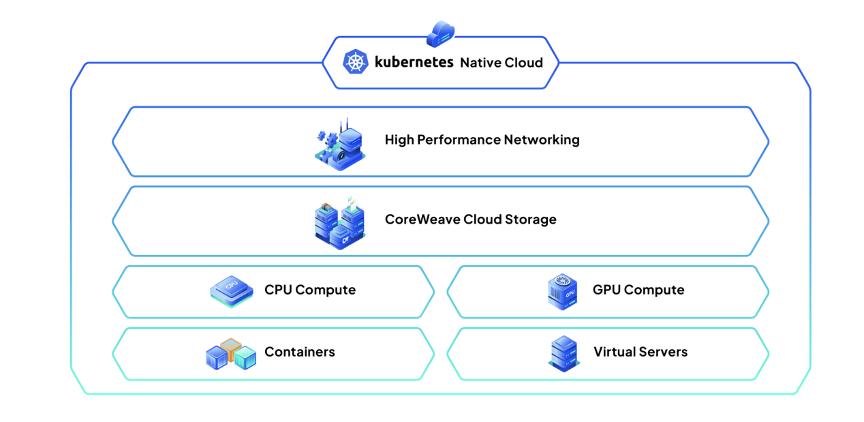

作者|李小东 CoreWeave的大火被看作是AI云注定颠覆传统云计算的一个开端。 从七年前的挖矿公司,长成一家AI云厂商,这被外界看来符合自身技术路线的转型,加上与英伟达的暧昧关系,助推CoreWeave——一家规模不算庞大的公司,在短时间内估值达到190亿美元,就在5个月前,它的估值才刚刚70亿美元。 短时间内估值翻倍的背后,是全球 GPU 加速云基础设施的爆炸性需求,以及当前的AI融资狂潮。和传统云计算厂商卖计算资源、存储空间和各种云服务不同,CoreWeave专注GPU云计算,特别是与AI领域的紧密联系。 简单来说,现在因为生成式AI(如聊天机器人、图像生成等)越来越火,训练和运行这些AI模型需要大量的计算能力。GPU(图形处理器)因为能同时处理很多任务,成为了这类计算的优选硬件。 但事实上,买GPU和维护它并不便宜,所以很多人会选择使用云计算服务。像亚马逊AWS、谷歌云和微软Azure这样的主流公司都提供了特别为AI工作准备的GPU。但人们发现,有些专门提供GPU服务的小公司,比如CoreWeave,比那些大公司更便宜。 举个例子,据媒体报道,在CoreWeave上租用一款流行的GPU,每小时不到2.4美元,但在AWS和谷歌云上都要花费3.5美元左右。换句话说,细微的价差和庞大的市场需求,正在将Gartner提到的“GPU即服务(GAAS)”这样一个新的概念,日渐催化成了一个庞大的市场。 2024年,CoreWeave公司官方预测年度营收约24亿美元,前两年分别是3000万和5亿,虽然体量上和AWS这些巨头相去甚远,但夸张的增长态势,已经不得不让所有人对这个新兴的行业侧目。 01 颠覆传统云厂商的铲子从哪来? CoreWeave之所以能被称为算力黄牛,是因为此前靠挖矿积累了大量的GPU。 简单来说,挖以太坊就像是一个巨大的数学竞赛,矿工使用计算机(特别是像英伟达这样的高性能GPU)来解一个叫“哈希函数”的难题。当他们用自己的GPU找到答案时,就赢得了一次挖矿的胜利,奖励就是以太币。 挖矿是一门技术活,更是体力活,为了获得更多的以太币,要挖更多的矿,与传统的CPU相比,GPU具有更高的并行处理能力和更强的计算性能,能够更快地执行复杂的加密算法。英伟达的GPU因卓越的性能和效率,成为了矿工们的首选铲子。 CoreWeave的三名创始人Michael Intrator、Brian Venturo和Brannin McBee都是华尔街背景,关注金融和科技领域,五年的挖矿经历,让他们通过各种方式获得了数万张高性能显卡,建立了不少数据中心。截至2018年末,CoreWeave部署超过5万张GPU,并且在挖矿逐渐没落的同时,借助算力资源转型做起了云计算的生意。 将CoreWeave和英伟达推向高峰的chatgpt,更准确地说是预训练大模型,因为训练这些大模型的数据量极其庞大,过程可以被拆解成不同的小任务,这就非常适合GPU做。产量有限,一个成本约3000美元的H100显卡可以卖到十倍价格。 据媒体报道,从宣布加入英伟达合作伙伴网络计划,到拿到首批英伟达HGX H100高性能计算平台,再到掌握将英伟达 H100作为抵押品获得融资,CoreWeave只用了不到三年。 之所以被英伟达青睐,外界普遍认为的核心是:在面对来自英特尔、AMD等半导体巨头以及OpenAI、微软等下游客户自研芯片的压力下,英伟达不得不既要抵御云厂商造芯片,又要进一步扩大GPU市场份额。所以芯片厂通过扶持不造芯片的CoreWeave、Lambda Labs等较小的云服务商,从而与微软等巨头能够形成间接竞争。 按照这样的逻辑,巨头在寻求GPU资源时,如果只能通过CoreWeave等公司间接获取,那么将需要支付更多的费用,包括购买GPU的费用以及使用CoreWeave等公司的服务费用。典型的例子就像刚与CoreWeave签订长期合作协议的微软,这样一来,作为最上游的英伟达仍然掌握最高的议价权。 CoreWeave依赖英伟达发财,就连它的创始人也坦然承认:“世界都在依赖英伟达,虽然我们也在了解不同的芯片和解决方案,但事实上,客户明确表示,目前他们需要构建产品和AI芯片类型,很大程度上是由英伟达基础设施推动的。” 但回过头来,这些其实还不足以论证CoreWeave被市场看好的根本原因。 本质上,押注CoreWeave的英伟达、前苹果高管、黑石等大量的资本,他们笃定另一个预判,传统的云服务商将被更新兴的AI云替代。 AI软件的发展速度非常迅猛,开发的训练过程需要更强大的计算资源,和更高效的云基础设施来支持不断增长,就连被定义为AI超大规模计算提供商的CoreWeave,有大量的GPU等设施,仍然供不应求。 就当前来看,现有的云基础设施大多是为可序列化工作负载设计的,它们更适合处理那些可以分解成一系列独立步骤并依次执行的任务;但AI工作负载的特性并不一样:它们通常需要进行大量的并行计算,并且需要实时地处理大量的数据。 在CoreWeave的CTO看来,他们不仅拥有大量的GPU作为生产力工具,更重要的是其软件技术非常先进,这是它能够比其他公司更好地利用GPU服务器,确保客户获得最佳性能的原因。 02 更灵活、更划算,CoreWeave能满足什么? 为什么选择CoreWeave,它的官网上有很直接地回答: CoreWeave是一家专门为企业级GPU加速工作负载提供云服务商。他们的Kubernetes原生基础设施专为机器学习、VFX渲染、像素流和批处理等计算密集型用例而构建,与传统云厂商相比,速度最高可提高35倍,成本降低80%。 用创始人的Brannin的话简单来说,CoreWeave的云不是简单地加上GPU然后让用户能够使用它。它其实是一个复杂的系统,像是一个大舞台的导演,管理着所有的资源和设备,让用户可以方便地访问和使用这些资源。 这和那些大公司的云不同,因为传统云主要是为了托管网站和存储数据,而CoreWeave是从头开始打造的,专注于运行AI和其他需要大量并行计算的任务。这是它的核心优势之一,对以前不能参与的决策,客户有更自由,“严格的资源配额和等待数小时才能启动GPU已经成为过去,现在你可以在几秒钟内调用、扩大和缩小数千个GPU。” Brannin喜欢打一个比喻,CoreWeave和传统云厂的区别,就像特斯拉和福特汽车。福特当然可以造出像特斯拉一样的汽车,但这意味着他们需要经历范式转变,因为涉及的是整个供应链和整体业务,需要推翻过去重新开始,且容易陷入创新者困境,大公司往往不愿这么做。 当然,这种对AI的专一性,也直接造就了CoreWeave在给AI公司服务时的专业性。 CoreWeave的主要产品有7类,除了提供高性能计算平台H100和最齐全的GPU,也提供CPU来满足不同负载需求,还有完全托管的Kubernetes服务,消除了客户管理Kubernetes集群的负担,使他们能够专注于应用程序的开发和部署;以及NVMe文件系统卷,这种高性能存储适用于分布式机器学习训练、VFX渲染、生命科学批处理和元宇宙像素流等工作负载。 除此以外,CoreWeave使用InfiniBand技术建立了高性能的网络,相当于给每一辆车(GPU)搭建高速公路,能够满足大规模数据处理和传输的需求,从而有助于AI产品更快速地发展和规模化。 客观来讲,CoreWeave的产品体系覆盖了高性能计算的各个方面,从硬件资源到软件服务,让模型训练、托管、微调以及推理服务变得简单。 至于具体的效果,对比A100,H100能将大型模型的AI训练速度提高9倍,推理速度提高三十倍。H100的性能目前维持在行业第一,这种速度,加上NVIDIA Quantum-2InfiniBand平台在市场上最低的网络延迟,将AI模型的训练时间缩短至几天或几小时,而不是几个月。 以做NFT的Procedural Space为例,这是数万个独特的、程序生成的行星NFT的集合。每个行星都是使用独特的算法生成的,这些算法控制着行星的颜色、地形构造、海洋、文明等,所有 Procedural Space 行星均制作为一分钟的 4K 视频,展示行星的完整旋转。由于负载量大,帧速率为每秒30帧,因此需要1800万个高分辨率帧。 以往他们用过其他的渲染引擎,但效果并不大好,但通过与CoreWeave合作,Procedural Space 能够在短短一周内渲染、存储、压缩、编码和制作100GB的4K高分辨率图像,而成本仅为原来的六分之一。 那为什么说CoreWeave是当下AI公司最具性价比的选择? 一方面,CoreWeave提供了业内价格最低、最广泛的NVIDIA GPU系列选择,客户可以根据自己的工作负载选择合适的GPU,从而确保性能和成本的最优化。并且与其他云提供商不同,CoreWeave 在绝大多数用例中不收取区域间传输、工作站数据或出口等费用,这样客户就不用担心数据传输会花很多钱。 另一方面,CoreWeave提供了按需定价模式,意味着客户只需支付他们实际使用的资源费用,无需签订长期合同或做出任何承诺。这种灵活性使得客户能够根据自己的实际需求进行扩展或缩减,从而节省成本。如果客户需要长期或大量使用,他们还有折扣。这也就不难解释,CoreWeave的云基础设施的速度会比通用公共云快35倍,成本却低了80%。 03 留给传统云厂商的时间不多了 Brian Venturo作为CoreWeave的CTO,提到如果有一种新的芯片性能与英伟达相当或更好,那意味着市场上出现了一个强有力的竞争对手。 想象一下,如果你家附近新开了一家和沃尔玛一样大的超市,那么沃尔玛的生意可能会受到一些影响,因为消费者现在有了更多的选择。对于 CoreWeave 来说,这个新的芯片就像那家新开的超市,可能会吸引一些原本使用英伟达芯片的客户。 但Brannin McBee 提到的一个观点是,一种芯片的前两到三年主要用于模型训练,然后四到五年用于推理执行。这意味着即使有了新芯片,现有的英伟达芯片在一段时间内仍然会很有用,因为很多公司可能还在使用它们进行推理执行。 除此以外,英伟达不仅仅提供芯片,它还努力建立一个围绕其硬件的开放生态系统。这意味着很多软件、工具和服务都是与英伟达芯片紧密集成的。其他制造商虽然可以制造性能相近的芯片,但要建立一个像英伟达那样的生态系统非常困难。 相比大型云厂商(如谷歌、微软和AWS)需要投入大量的资金来建设和维护庞大的数据中心,还要提供一些低利润的服务来吸引和保持客户。CoreWeave这样的公司,由于它们更专注于提供优质的AI服务,所以在基础设施方面的投入相对较小,这使得它们更容易取得成功。 就像前面说的那样,传统云厂商是有“基础设施包袱”的。 不过现实情况里,随着谷歌、微软和AWS等传统云厂商开始加大对定制硬件的投资,CoreWeave也在经历挑战,这里的关键就在于,后者能否持续提供大量的GPU并保持价格上的竞争力。 对于一家AI公司的一个模型而言,退出训练阶段后,在产品上市的前两年内,商业化阶段的推理执行仍然至少需要百万个GPU,但目前市场的供给远不足够,这将是一个长期的挑战。换句话说,未来不排除越来越多像CoreWeave的公司出现,毕竟AI这股洪流的到来已经是个确定性的话题。